OLLAMA 설치 가이드

AMD GPU를 사용하는 유저를 위한 간단한 OLLAMA 구축 및 관리 방법을 제공합니다.

다음 목록에 자신이 해당하는지 확인 후 진행해주세요.

- Debian linux

- OLLAMA

- AMD GPU

- Docker

Docker설치

먼저, Docker와 Docker-compose가 필요합니다. 설치 방법은 인공지능 컴퓨터 만들기를 참조하세요.

1. 설정 디렉토리 준비

OLLAMA용 Docker 설정 디렉토리를 생성하고 이동합니다.

sh

mkdir -p ~/app/ollama

cd ~/app/ollama2. Docker 설정 파일 생성

OLLAMA를 실행할 docker-compose.yml 파일을 생성합니다.

sh

nano docker-compose.yml아래 내용을 파일에 추가합니다.

yml

version: "3.7"

services:

ollama-rocm:

container_name: ollama-rocm

image: ollama/ollama:0.1.29-rocm

volumes:

- /var/opt/ollama-orcm:/root/.ollama

devices:

- /dev/dri

- /dev/kfd

restart: unless-stopped

ollama-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: ollama-webui

ports:

- "8080:8080"

volumes:

- /var/opt/open-webui:/app/backend/data

environment:

- 'OLLAMA_BASE_URL=http://ollama-rocm:11434'

restart: unless-stopped저장 후 종료합니다. (Ctrl + o, Enter, Ctrl + x)

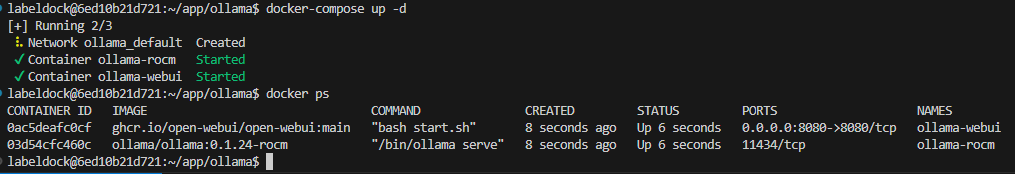

3. OLLAMA 실행 및 확인

OLLAMA를 시작하고, 두 개의 컨테이너가 정상적으로 실행되었는지 확인합니다.

sh

docker-compose up -d

docker ps

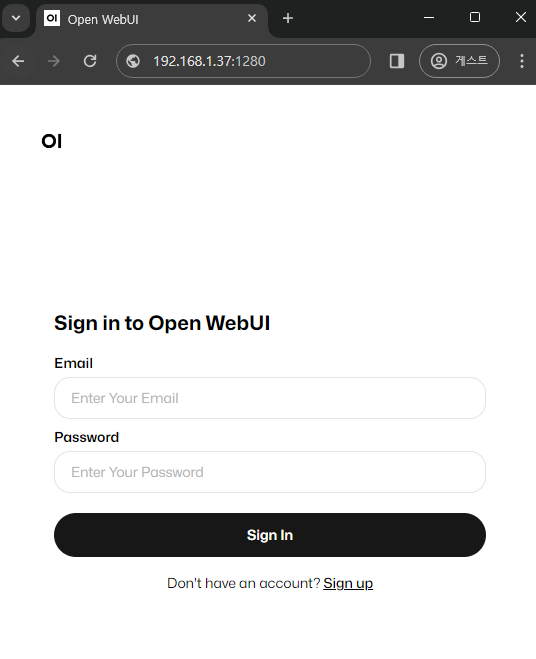

웹 브라우저에서 http://<YOUR_IP>:8080로 접속하여 로그인 화면을 확인하세요. IP 주소 확인이 필요하면 ip a | grep inet를 사용하세요.